AIテストは、AI技術がソフトウェア製品やデジタルサービスを急速に再定義する現代において、組織が取り組むべき最も重要なプロセスの一つです。

従来のソフトウェアテストは、主に「決定論的ロジック」に焦点を当てていました。これは、システムに同じ入力を与えれば、常に同じ出力が得られるという前提に基づくものです。しかし、AIアプリテストやAI搭載システムテストの領域では、システムの挙動は根本的に異なります。機械学習(ML)、ディープラーニング、そして大規模言語モデル(LLM)を搭載したシステムは、「確率的な出力」を行い、時間の経過とともに学習・適応し、データの品質に大きく依存するという特徴があります。

このようなシフトにより、AIテストは、AI搭載アプリケーション、AIチャットボット、LLMベースのシステムを開発する組織にとって不可欠な規律となりました。AIソフトウェアテストにおいては、単に「機能が動作するか」を確認するだけでは不十分です。そのAIシステムが信頼でき、安全で、倫理的であり、かつビジネスの目標に整合した挙動をするかどうかを評価することが求められます。

本記事では、AIテストとは何か、従来のアプリケーションテストとの決定的な違い、AIモデルテストにおいて何を検証すべきか、そして信頼性が高くスケーラブルなAIテストを実現するポイントについて詳しく解説します。

AIテストの基礎知識

AIテストとは

AIテストとは、AIシステムが意図した通りに機能するかを多角的に評価するプロセスのことです。具体的には、精度、安定性、公平性、セキュリティ、ユーザビリティ、そして適応性といった側面から検証を行います。

従来のソフトウェアテストとは異なり、AIテストは事前に定義された「期待される出力」だけに依存することはありません。その代わり、ベンチマーク、指標、評価フレームワークを用いて、AIシステムの挙動が許容できる範囲に収まっているかどうかを判定します。

AIテストの対象範囲は以下の通りです。

-

AI搭載アプリ

-

大規模言語モデル(LLM)ベースのシステム

-

AIチャットボットおよび仮想アシスタント

-

レコメンデーションエンジン

-

予測分析プラットフォーム

-

自律型および半自律型システム

その最終的な目的は、AIシステムテストを通じて、システムが信頼でき、安全であり、実環境での展開に適していることを保証することにあります。

AIシステムのテストが極めて重要である理由

AIの社会実装が加速する中、堅牢なAIソフトウェアテストの重要性はますます高まっています。AI特有の挙動により、テスト不足に伴うリスクは従来のソフトウェアシステムよりもはるかに深刻です。主な理由は以下の4点です。

AIシステムにテストの大切な役割

1. 非決定論的な挙動

機械学習や生成AIに基づくAIモデルテストにおいて最も特徴的なのが、「確率的な出力」です。

モデルのアーキテクチャ、推論パラメータ、そして継続的な学習メカニズムなどの要因により、同じ入力を与えてもタイミングによって異なる結果が出ることがあります。適切なテストを行わないと、この変動性が予測不能なシステム挙動につながり、一貫した品質と信頼性の担保が困難になります。

2. データへの高い依存度

学習データは、AIモデルの挙動を直接的に決定づけます。不完全なデータ、バイアスのあるデータ、古いデータ、あるいは低品質なデータは、不正確な予測や不公平な判断、危険な出力の原因となります。

そのため、AIテストはモデルのロジックだけでなく、厳格なデータ検証、バイアス検知、代表性のチェックまで網羅する必要があります。多くの場合、データに関連する問題はテスト中やデプロイ後に初めて表面化するため、早期かつ継続的な検証が不可欠です。

3. ビジネスおよび倫理的リスク

AIシステムが誤った判断や偏った判断を下すと、金銭的損失、セキュリティ上の脆弱性、法規制違反、そして社会的信用の失墜といった重大な結果を招く可能性があります。

特にAIチャットボットやレコメンデーションシステムのような顧客向けアプリでは、一貫性のない出力や誤解を招く出力がユーザーの信頼を即座に損ないます。AI搭載システムテストは、こうしたリスクが実社会での事故に発展する前に特定する重要な役割を果たします。

4. システムの継続的な進化

多くのAIモデルは、デプロイ後も再学習、ファインチューニング、プロンプトの最適化などを通じて更新され続けます。これらの変更は、意図せずパフォーマンスを低下させたり、新たなリスクをもたらしたりする可能性があります。

したがって、AIテストは一回限りの活動ではありません。システムライフサイクル全体を通じて、継続的なモニタリング、回帰テスト(リグレッションテスト)、パフォーマンスのベンチマーク評価を行う継続的なプロセスである必要があります。

AIシステムテストと従来のシステムテスト:決定的な違いとは?

従来のシステムテストとAIシステムテストの根本的な違いは、「何を評価対象とするか」にあります。

AIシステムテストと従来のシステムテストの違い

従来のテストは、システムが事前に定義された厳格なルールに従って動作するかどうかを検証します。これとは異なり、AIテストは、システムが実世界の条件下でどれだけ「適切に」振る舞うかを評価します。

従来のアプリケーションは「決定論的」な出力を生成するため、再現性の確保や明確な合否判定が比較的容易です。一方、AI搭載システムは「確率的」であり、データ駆動型です。そのため、テストケースは出力の完全な一致を確認するのではなく、許容範囲、挙動の一貫性、堅牢性、そしてリスク軽減に焦点を当てる必要があります。

以下の表は、両者の主な違いを比較したものです。

|

システムの挙動 |

同じ入力であれば、常に同じ出力が得られる |

まったく同じ入力であっても、出力が変動する可能性がある |

|

テストの目的 |

固定された要件に対する正当性を検証する。 |

品質、信頼性、および期待される挙動との整合性を評価する |

|

合否判定基準 |

定義されたルールに基づく二値的な結果(パス/失敗) |

精度、品質スコア、リスク許容度を用いた閾値ベースの評価 |

|

テストデータの役割 |

静的で、明確に定義されたテストケースを使用 |

データの品質、多様性、およびバイアス管理に決定的に依存する |

|

エッジケースの扱い |

明示的に定義され、その数は限定的 |

探索的テストやモニタリングを通じて発見されることが多く、創発的である |

|

再現性 |

環境間での再現性が高い。 |

モデルのバージョン、データの変化、プロンプトの影響により、再現性は限定的 |

|

回帰テスト(リグレッション) |

コードの変更によってトリガーされる。 |

データの更新、モデルの再学習、プロンプトの修正によってトリガーされる |

|

非機能要件の焦点 |

パフォーマンス、セキュリティ、ユーザビリティ |

パフォーマンス、安全性、倫理、堅牢性、信頼 |

|

ライフサイクル |

主にリリース前のテストに限定される |

学習、デプロイ、本番運用を含む継続的なテストが必要 |

モデルの種類とテストにおける重要な考慮事項

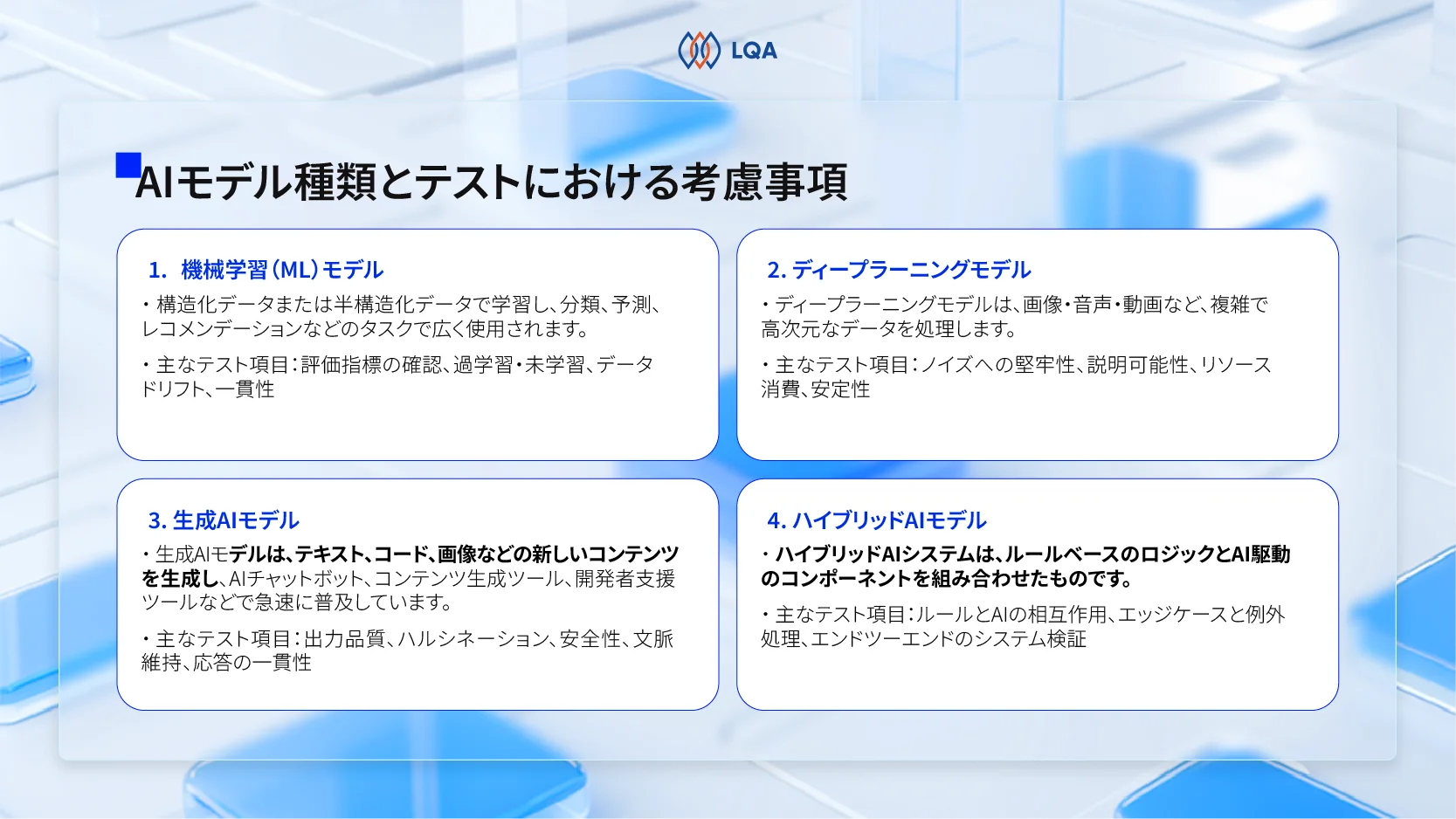

AIシステムは、単一の種類のモデルだけで構築されているわけではありません。

組織はビジネス上の課題や技術的なアーキテクチャに応じて、従来の機械学習モデル、ディープラーニングモデル、生成AIモデル、あるいはこれらを組み合わせたハイブリッドなアプローチを採用します。

それぞれのモデルタイプには独自のテスト要件が存在するため、万能なのアプローチを適用するのではなく、各モデルの特性に合わせてAIモデルテスト戦略を最適化することが不可欠です。

モデルの種類とテストにおける重要な考慮事項

機械学習(ML)モデル

機械学習モデルは通常、構造化データまたは半構造化データを用いてトレーニングされ、分類、予測、レコメンデーションなどのタスクで広く使用されています。代表的な例として、与信スコアリングモデル、需要予測システム、レコメンデーションエンジンなどが挙げられます。

MLモデルのテストでは、主にパフォーマンスの信頼性と汎化性能に焦点を当てます。これらのモデルは過去のデータからパターンを学習するため、トレーニングデータだけでなく、未知のデータセットに対してどれだけ正確に機能するかを検証することが極めて重要です。

主なテスト項目:

-

モデルの評価指標:ユースケースに応じた正解率、適合率、再現率、F1スコアの検証

-

過学習と未学習の検出:モデルがトレーニングデータ以外にも適応できるかの確認

-

データドリフトの監視:時間の経過とともにデータの分布が変化していないかの特定

-

パフォーマンスの一貫性:地域、期間、ユーザーセグメントなど、異なるデータセット間での精度維持

適切なテストが行われない場合、開発中には正確に見えたMLモデルが、本番環境でのデータ変化や隠れたバイアスによって機能不全に陥るリスクがあります。

ディープラーニングモデル

ディープラーニングモデルは、画像、音声、動画、自然言語などの複雑で高次元なデータを処理するように設計されています。これらは、コンピュータビジョン、音声認識、自然言語処理(NLP)システムの基盤であり、顔認証、音声アシスタント、自動運転、自動翻訳エンジンなどに活用されています。

ディープラーニングのテストは、単なる精度の測定にとどまりません。その複雑さゆえに、堅牢性、透明性、および運用上の安定性に関する課題が生じます。

主なテスト項目:

-

ノイズや敵対的入力への堅牢性:予期せぬ予測を引き起こす可能性のある入力への耐性

-

モデルの説明可能性:特に規制の厳しい分野や高リスク領域での判断根拠の明確化

-

リソース消費と推論パフォーマンス:遅延やハードウェア使用率の検証

-

多様な入力条件下での安定性:画質の低下や言語のバリエーションなどへの対応

ディープラーニングにおけるテストの目的は、入力条件が理想的でない場合でも、モデルが信頼性の高い挙動を維持できることを保証することにあります。

生成AIモデル

規模言語モデル(LLM)を含む生成AIモデルは、テキスト、コード、画像などの新しいコンテンツを生成します。これらは、AIチャットボット、コンテンツ生成ツール、開発者支援ツールなどで急速に普及しています。

生成AIのテストでは、「正解かどうか」だけでなく、出力の品質と安全性に重点が置かれます。

主なテスト項目:

-

出力の品質:回答の関連性、一貫性、流暢さ。

-

ハルシネーションの検出:モデルが事実とは異なる情報や捏造された情報を生成していないかの確認。

-

安全性とセキュリティリスク:有害なコンテンツや機密情報の漏洩リスクの排除。

-

コンテキスト保持と指示の遵守:特にマルチターン(複数回のやり取り)会話における文脈理解。

-

応答の一貫性:類似したプロンプトに対して矛盾しない回答ができるか。

これらの要素は、AIチャットボットテストやLLMテストにおいて特に重要であり、ユーザーの信頼は、システムが予測可能で責任ある挙動を示すかどうかにかかっています。

ハイブリッドAIモデル

ハイブリッドAIシステムは、ルールベースのロジックとAI駆動のコンポーネントを組み合わせたものです。このアプローチは、AIの柔軟性を活用しつつ、厳格なビジネスルールを適用したい場合によく用いられます。

ハイブリッドモデルのテストでは、システムレベルでの挙動に焦点を当てます。

主なテスト項目:

-

決定論的ルールとAI出力の相互作用:ルールとAIが競合した際の挙動確認

-

エッジケースと例外処理:予期せぬ状況への対応能力

-

エンドツーエンドのシステム検証:さまざまなシナリオを通じた全体的な動作確認

ハイブリッドシステムにおいて成功するテストとは、事前に定義された制約やビジネスロジックに違反することなく、AIが意思決定を強化できているかを確認することです。

AIシステムテストの評価項目と範囲:何を検証すべきか?

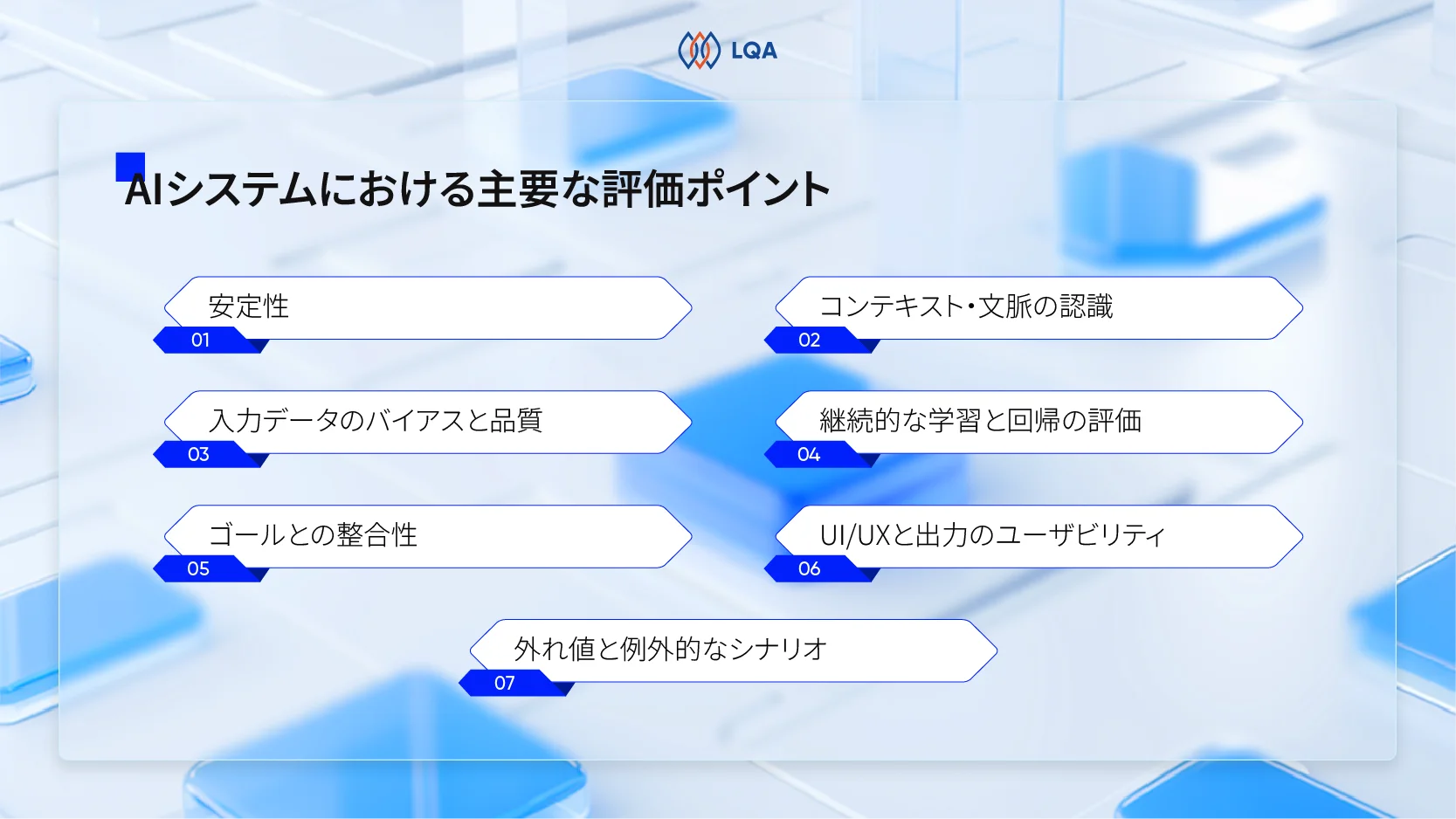

本セクションでは、実環境で信頼性の高いパフォーマンスを保証するために、AIシステムテストにおいて考慮すべき主要な評価ポイントと、必要なテスト範囲について解説します。

AIシステムにおける主要な評価ポイント

AIシステムを評価するポイント

安定性

安定性とは、類似した条件下で類似した入力を与えた際に、AIが一貫性のある出力を生成できる能力を指します。AIシステムにおいて多少の変動は許容されますが、過度な出力の揺らぎはユーザーの信頼を損ない、システム全体の信頼性を低下させます。

テストでは、時間の経過や異なる利用シナリオにおいて、出力の変動が許容範囲内に収まっているかを評価する必要があります。

入力データのバイアスと品質

AIの挙動は、入力データの品質と代表性に大きく左右されます。

AIテストでは、学習データや推論データにバイアス、欠損、不整合が含まれていないかを確認する必要があります。これらが存在すると、不公平な判断や不正確な結果につながる恐れがあります。データの完全性、ラベリングの正確性、分布の偏りを検出し、バイアスのあるデータがモデルの意思決定にどう影響するかを検証します。

ゴールとの整合性

技術的な観点では高性能なAIシステムであっても、ビジネスやユーザーの目的を満たしていない場合があります。

ゴールとの整合性テストは、AIの出力が意図されたユースケースをサポートし、正しい問題を解決し、組織のポリシーや倫理ガイドラインに準拠していることを保証するために行います。ビジネス目標と相反する意図しない挙動を防ぐ上で重要です。

コンテキスト・文脈の認識

AIチャットボットやレコメンデーションエンジンなどの多くのAIシステムは、ユーザーの場所、時間、対話履歴、状況といったコンテキストに基づいて挙動を適応させる必要があります。

テストでは、各インタラクションを独立したものとして扱うのではなく、AIが文脈の変化を適切に解釈し、それに応じた応答ができるかを検証します。

継続的な学習と回帰の評価

再学習やモデルの更新によって進化するAIシステムには、パフォーマンスの後退のリスクが伴います。

新バージョンが既存の機能を低下させたり、予期せぬ挙動を引き起こしたりしないことを確認するために、継続的な評価と回帰テストが不可欠です。これにより、長期的なシステムの信頼性を維持します。

UI/UXと出力のユーザビリティ

AIの出力が技術的に正しくても、表示方法が悪かったり、回答が不明瞭だったりすれば、ユーザビリティは低下します。特にAIアプリテストにおいては、生成された出力がユーザーにとって理解しやすく、実用的であり、期待値と一致しているかを評価します。

Human-in-the-Loop(HITL)によるフィードバックや反復的なユーザビリティテストを組み込むことで、単なるデータ生成ツールから、シームレスなユーザー体験を提供する製品へと進化させることができます。

外れ値と例外的なシナリオ

実環境では、予期せぬ入力や稀なケースが頻繁に発生します。

AIテストには、意図的にエッジケースや異常なシナリオを含めるべきです。曖昧な指示、不完全なデータ、極端な条件下でも、システムがクラッシュしたり危険な結果を出したりせず、安全に処理できるかを確認します。

AIテストの範囲の定義

評価ポイントに加え、テストの範囲を明確に定義することも重要です。効果的なAIテストは、以下の複数のレイヤーにまたがって行われます。

-

データ層:学習データ、テストデータ、および本番の入力データ

-

モデル層:推論の挙動とパフォーマンス指標

-

システム層:他のコンポーネントやワークフローとの統合

-

ユーザー層:インタラクションの品質とユーザビリティ

-

ライフサイクル全体:リリース前の検証からデプロイ後のモニタリングまで

LQAは、データアノテーションからAI搭載アプリ開発、そして高品質なテストまでの包括的なサービスを提供し、貴社のAIプロジェクトを成功に貢献します。AI特有の課題を熟知したプロフェッショナルチームが、確実な品質保証を実現します。

AIテストにおける4つの実践的な課題

AIテストの重要性は広く認知されていますが、実際のプロジェクトでそれを効果的に実装しようとすると、多くの実践的な課題に直面します。これらの課題を正しく理解することは、現実的で持続可能なAIテスト戦略を設計するために不可欠です。

AI出力の非一貫性

AIテストにおいて最も一般的な課題の一つが、出力の一貫性がないことです。

前述の通り、従来のソフトウェアとは異なり、AIシステムは、同じ入力に対しても異なる応答を返す可能性があります。推論パラメータ、コンテキストの履歴、あるいはモデルの更新といった要因が出力の挙動に影響を与えます。

この「非一貫性」により、従来の「パス/失敗」による判定だけでは不十分となります。基準となる正解と異なる回答が返ってきたとしても、それが必ずしも「間違い」であるとは限らないからです。しかし、制御されていない変動は、予測不可能なユーザー体験につながります。

その結果、AIテストのアプローチは、出力の完全一致を確認することから、挙動パターンの評価、品質の範囲、そして許容できる閾値の評価へとシフトする必要があります。

学習データへの依存とバイアス

AIシステムは、トレーニングやファインチューニングに使用されたデータに強く依存します。

人口統計学的属性、言語表現、過去のトレンドなどに関連して学習データに埋め込まれたバイアスは、多くの場合、開発段階では微細で検知が困難です。

多くのケースにおいて、これらの問題は本番環境でAIシステムがより広範で多様なユーザーと対話して初めて表面化します。したがって、AIシステムテストには以下のようなプロアクティブな戦略が求められます。

-

データセット内の潜在的なバイアスを特定

-

異なるユーザーセグメント間でのパフォーマンスを評価

-

モデルの挙動における意図しない相関関係を検出

テスト段階でデータ依存性とバイアスに対処しなければ、AIシステムは技術的には正確であっても、社会的・倫理的に問題のある結果を出力してしまう恐れがあります。

限定的な再現性

「再現性」は従来のソフトウェアテストにおける基礎ですが、AIシステムにおいてこれを実現するのは著しく困難です。学習データの更新、プロンプトの修正、あるいはモデルバージョンの変更といった些細な変化が、出力に目に見える違いをもたらすことがあります。

この「限定的な再現性」は、デバッグ、回帰テスト、および根本原因分析を複雑にします。テスト結果を一貫して再現できない場合、システムに加えられた変更が「真の改善」なのか、それとも「意図しない改悪」なのかを判断することが難しくなります。

そのため、AIテスト戦略は、品質とリスクに対する管理を維持しつつ、ある程度の変動性を考慮に入れた設計にする必要があります。

テスト設計の複雑さとROI測定の難しさ

AIシステムのための有意義なテストケースを設計することは、従来のアプリケーションに比べて本質的に複雑です。テスターは、機能的なシナリオだけでなく、振る舞いのパターン、エッジケース、そして長期的なパフォーマンスの傾向まで考慮しなければなりません。

さらに、AIテストの投資対効果(ROI)を測定することも困難です。テストの価値は多くの場合、「欠陥の検出」よりも、「レピュテーションの失墜、法規制上の問題、ユーザーの信頼低下」といったリスクを回避することにあります。これらの利益は数値化しにくいため、組織にとってテストコストと期待される価値のバランスを取ることが難しい課題となります。

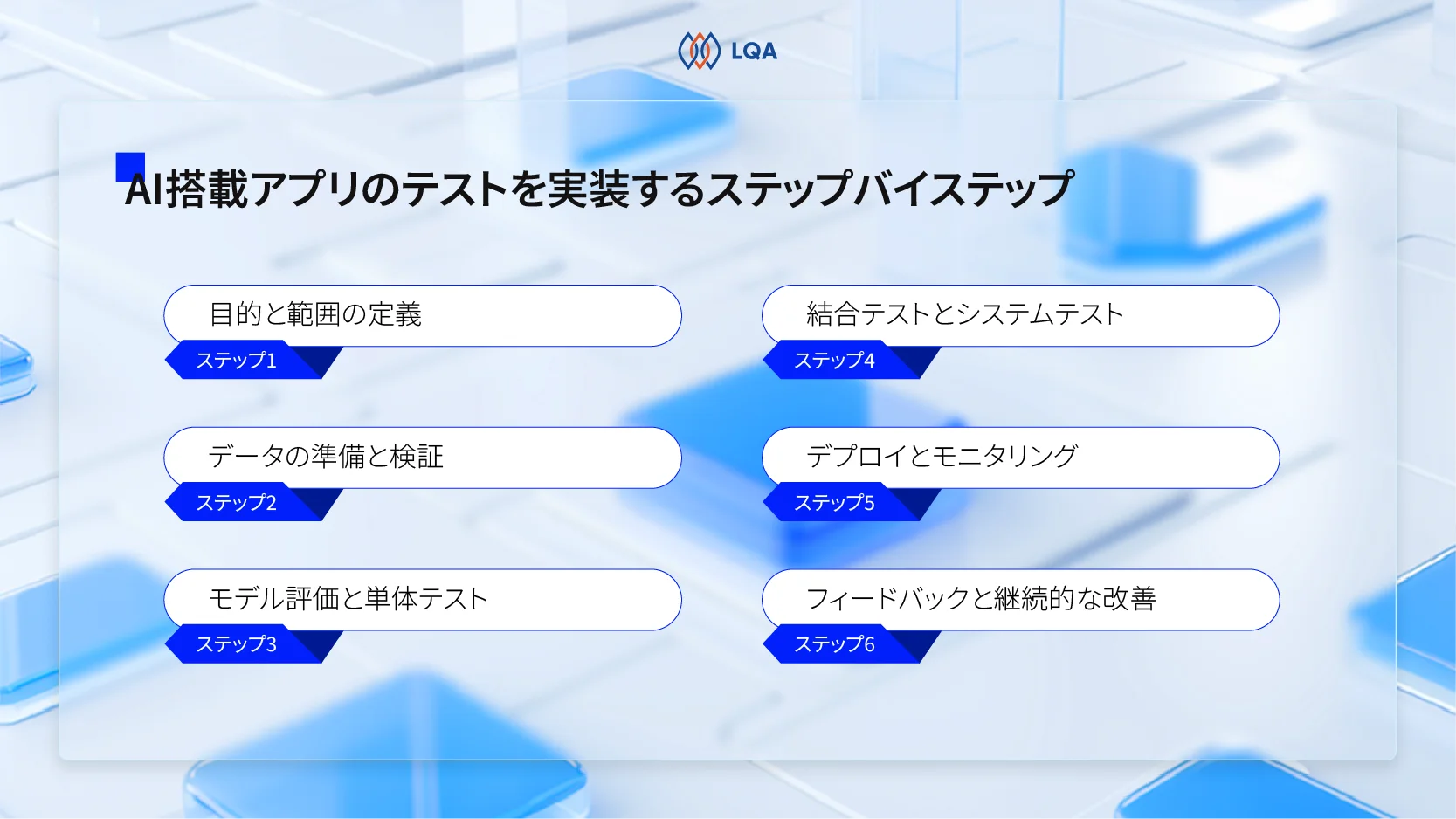

AI搭載アプリのテスト方法:実践的な6つのステップ

AIアプリテストには、構造化されつつも柔軟なアプローチが求められます。

AIシステムはデータ、モデル、そしてアプリケーションロジックの複合体であるため、テストは複数のレイヤーを網羅し、時間の経過とともに継続的に進化させる必要があります。

以下のステップバイステップのアプローチは、ライフサイクル全体を通じてAI搭載アプリをテストするための実践的なフレームワークです。

AI搭載アプリのテストを実践するガイド

ステップ1:目的と範囲の定義

最初のステップは、AIシステムにおける成功の定義を明確にすることです。共通の目的がなければ、テストの取り組みは断片的になり、効果を発揮しません。

この段階で、チームは以下を明確にする必要があります。

-

ビジネスおよびユーザーの目標:AIシステムがサポートすべき具体的な成果

-

軽減すべき主要なリスク:バイアス、セキュリティ問題、誤った意思決定など

-

パフォーマンスのベンチマーク:品質として許容される閾値

-

倫理的・法的・コンプライアンス要件:守るべき規制やガイドライン

このステップにより、機能テストと非機能テストの適切なバランスが決定され、開発の初期段階から信頼性やセキュリティといった品質属性に対処できるようになります。

ステップ2:データの準備と検証

AIシステムはデータ駆動型であるため、テストはデータから始まらなければなりません。データの品質が低ければ、どんなに高度なモデルでも機能不全に陥ります。

主なテスト活動は以下の通りです。

-

データセットの検証:トレーニングデータ、検証用データ、テストデータの妥当性確認

-

バイアスや不均衡のチェック:データの偏りや欠損値の確認

-

一貫性の確認:複数のソース間でのデータ整合性の検証

-

合成データの活用:稀なケースや極端なエッジケースをシミュレーションするために使用

厳格なデータ検証は、後の工程で行う回帰テストを支え、デプロイ後の予期せぬ挙動のリスクを軽減します。

ステップ3:モデル評価と単体テスト

データの検証が完了したら、次はモデルそのものに焦点を当てます。このステップでは、制御された条件下でのモデルレベルの評価を行います。

代表的な活動は以下の通りです。

-

モデル指標の評価:正解率、再現率、適合率などの測定。

-

プロンプトのバリエーションテスト:特にLLMベースのシステムにおいて、異なる指示に対する挙動を確認

-

ブラックボックステスト: モデルの内部ロジックに依存せず、入出力の結果を評価

-

挙動の一貫性検証:事前に定義されたシナリオ全体での一貫性を確認

AIモデルは決定論的ではありませんが、このステップによってパフォーマンスの基準と、許容される挙動の範囲を確立します。

ステップ4:結合テストとシステムテスト

AIモデルが単独で動作することは稀です。API、データベース、ユーザーインターフェース(UI)、外部サービスを含む大規模なシステムに統合されます。

このステップには以下が含まれます。

-

結合テスト:AIコンポーネントと他のシステムモジュール間の相互作用を検証

-

システムテスト:エンドツーエンドのワークフローと実際の利用シナリオを評価

-

環境ごとの評価:Webアプリテストやモバイルアプリテスト環境内でのAI挙動の確認

-

出力の表示確認:AIの出力がアプリケーション側で正しく処理・表示されているかの確認

このフェーズは、AIが本番に近い環境に組み込まれて初めて表面化する問題を特定するために極めて重要です。

システムテストのフェーズに関する詳細は、以下のブログ記事もご参照ください。

システムテストとは?目的、見積もり、実施方法、成功のポイントを解説

ステップ5:デプロイとモニタリング

リリース後、テストは「事前の検証」から「継続的な評価」へとシフトします。AIシステムは、データやユーザーの行動が絶えず変化する実環境で監視されなければなりません。

主な活動は以下の通りです。

-

パフォーマンス傾向と出力品質の監視:継続的なモニタリング

-

データドリフトと異常検知:データの分布変化や予期せぬ挙動の特定

-

回帰テストの実施:モデルの更新や再学習後のリグレッション確認

-

セキュリティテスト:AIのエンドポイントに対するペネトレーションテストなどの実施

このフェーズはアジャイルテストの実践と一致することが多く、迅速なフィードバックと反復的な改善を可能にします。

ステップ6:フィードバックと継続的な改善

AIテストはデプロイによって終了するものではありません。ユーザーからのフィードバック、運用メトリクス、モニタリングからの洞察は、継続的にテストプロセスに還元されるべきです。

チームは以下を行う必要があります。

-

ユーザーフィードバックの収集と分析

-

ベンチマークと評価基準の更新

-

プロンプト、データパイプライン、モデル設定の改善

実際、効果的なAIテストとは直線的なプロセスではなく、継続的なサイクルです。これこそが、AI搭載アプリケーションの長期的な信頼と信用を支える鍵となります。

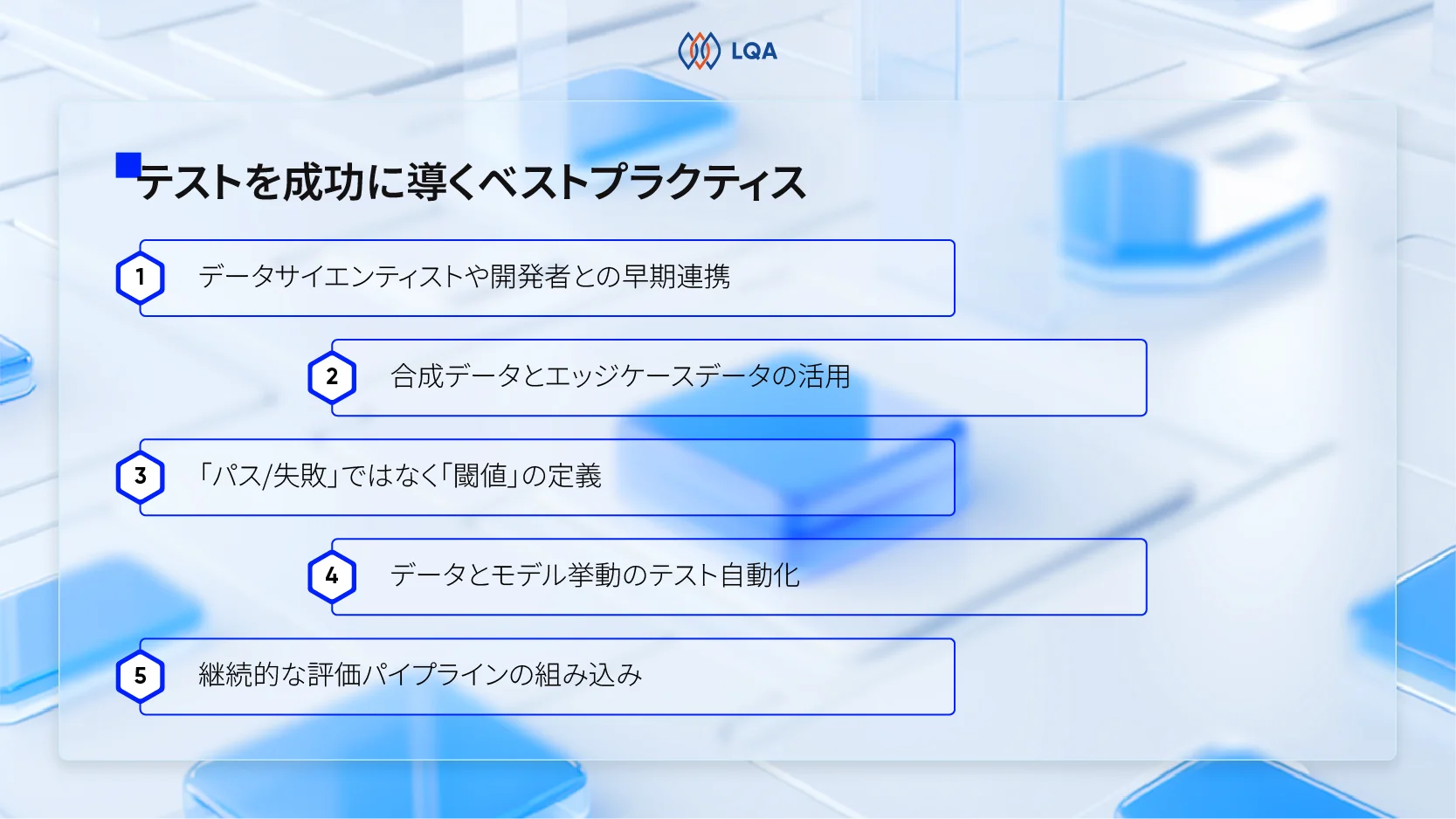

テストを成功に導くベストプラクティス

AIシステムがビジネスに不可欠なアプリケーションの中核を担うようになる中、テストの手法も従来の「検証」から、継続的かつ「振る舞い駆動」の評価へと進化させる必要があります。

ここでは、AIテストを成功させるための5つのベストプラクティスを紹介します。

テストを成功に導くベストプラクティス

データサイエンティストや開発者との早期連携

AIテストのリスクを軽減する最も効果的な方法の一つは、開発ライフサイクルの初期段階から品質保証担当者やテスターを巻き込むことです。なぜなら、AIシステムは開発の最後になってから「テスト可能」な状態にするのが極めて難しいからです。

データパイプライン、モデルの選定、評価指標に関する決定は、後のテスト実施可否に直接影響します。

早期に連携することで、最初から「テスト容易性」をシステムに組み込み、モデルのデプロイ前にリスクを特定し、エンジニアリング、データサイエンス、ビジネスチーム間で評価基準を統一できます。この共通理解が、「技術的には正しいが、実際のユーザーやビジネスの期待を満たさない」という事態を防ぎます。

合成データとエッジケースデータの活用

実データだけでは、AIシステムが直面する可能性のあるすべてのシナリオをカバーすることは困難です。ここで重要な役割を果たすのが、「合成データ」と「エッジケースデータ」です。

合成データは実データを置き換えるものではありませんが、システムの境界を意図的に探るために使用すべきです。

稀な条件、故障モード、極端な入力をシミュレーションすることで、チームはストレス下でのAIシステムの挙動を観察できます。このアプローチは、安全性の境界を検証したり、曖昧で不完全な情報に対してモデルがどう反応するかを理解したりする上で特に価値があります。これらは、AIの失敗が最も高いリスクを招く領域でもあります。

「パス/失敗」ではなく「閾値」を定義する

従来のテストは「パス(合格)」か「失敗(不合格)」かという二値的な結果に大きく依存しています。しかし、AIシステムは確率的な空間で動作するため、そのような白黒はっきりした判定は現実的でない場合が多々あります。

より実践的なアプローチは、許容できるパフォーマンスの閾値を定義することです。

AIの出力が「正解かどうか」を問うのではなく、「合意された精度の範囲内か」「品質スコアは満たしているか」「リスク許容度内に収まっているか」を評価すべきです。このシフトにより、品質と信頼性の管理を維持しつつ、より客観的にAIシステムを評価できるようになります。

データとモデル挙動のテスト自動化

継続的に進化するAIシステムに対し、手動テストだけで対応し続けることは不可能です。特にデータの品質や長期的なモデルの挙動を監視するためには、自動化がAIテストのスケーリングにおいて重要な役割を果たします。

自動化された評価プロセスは、継続的なリグレッション検知をサポートし、挙動の変化を特定し、再現性のあるテストパイプラインを実現します。これは、モデルが頻繁に再学習されたり、プロンプトが反復的に改善されたりする場合に特に重要です。

自動テストの基礎や導入メリットについては、以下の記事で詳しく解説しています。

継続的な評価パイプラインの組み込み

最後に、AIテストは単発の活動として存在すべきではありません。CI/CDパイプライン、MLOpsワークフロー、そして本番環境のモニタリングシステムに評価プロセスを統合することで、デプロイ後も長くテストが継続されるようにします。

この継続的なアプローチにより、チームは問題を早期に検知し、変化に迅速に対応し、AI搭載アプリケーションの長期的なパフォーマンスと信頼を維持することが可能になります。

ソフトウェアテストとAI品質保証におけるLQAの専門性

ベトナム初の独立系ソフトウェアテスト企業として、LQA(Lotus Quality Assurance)は、複雑でミッションクリティカルなシステムに対し、長年にわたり高品質なテストサービスを提供してきた豊富な実績があります。

エンドツーエンドのソフトウェアテストにおける確かな実績

LQAは、手動テストから自動テストの両方を駆使し、ソフトウェアのライフサイクル全体をカバーする包括的なテストサービスを提供しています。

私たちのチームは、ブラックボックステストやリスクベースのアプローチを駆使し、Webアプリテスト、モバイルアプリテスト、そして組込ソフトウェアテストにおいて、複雑かつ急速に進化する環境下でもソフトウェアの信頼性を保証します。

LQAは、品質と安全性が絶対条件となる自動車テスト(ADASおよび自動運転支援システム)、Eコマース、金融、ゲーム、医療など、複数の業界において強力な専門知識を構築してきました。

AIアプリケーションテストにおける専門能力

LQAは従来の検証手法を超えた、構造化されたリスクベースのテストアプローチを適用します。

AIモデル評価、データ品質評価、結合テスト、システムテスト、そして継続的な回帰テストを組み合わせることで、AIシステムが実環境において信頼でき、安全で、倫理的に振る舞うことを保証します。

また、当社のテストフレームワークは、アジャイル、CI/CD、MLOpsのワークフローに適合するように設計されており、AIライフサイクルを通じた継続的な改善をサポートします。

深いテストの専門知識とドメイン知識、そして最新のAIテスト手法を融合させることで、LQAはお客様のイノベーションを、信頼できる本番対応ソリューションへと変革するお手伝いをします。

まとめ

AI搭載アプリは、ソフトウェアが価値を提供し、意思決定を行い、ユーザーと対話する方法を根本から変えつつあります。システムがより適応的でデータ駆動型になるにつれ、品質保証もまた、同レベルの厳格さと規律を持って進化しなければなりません。

AIテストの本質とは、信頼を検証し、リスクを制御し、インテリジェントなシステムが実環境の条件下で責任を持って動作することを確認することにあります。

AI品質エンジニアリングに早期から投資する組織は、信頼性、コンプライアンス、ユーザーの信用を維持しながら、イノベーションを拡大できる有利な立場にあります。

もし「AI出力の一貫性が保てない」「再現性が低い」「AIの品質をどう測定すればいいか不明確」といった課題がございましたら、ぜひLQAにご相談ください。

LQAは、AIシステムの性能評価にとどまらず、信頼性や責任性、さらには長期的な価値を確保することで、企業の競争力強化と持続的な成長を支援します。

-

Website: https://lotus-qa.com/jp/

-

Tel: (+84) 24-6660-7474

-

Mail: [email protected]